أصبحت نماذج Gemini AI من Google مكونًا أساسيًا في نواقل هجمات المتسللين التي ترعاها الدولة. على الرغم من أن استخدام الذكاء الاصطناعي قد تزايد في اختراق القبعة البيضاء والسوداء في السنوات الأخيرة، إلا أن جوجل تقول الآن إنه يتم استخدامه في جميع أجزاء عملية الهجوم، بدءًا من الاستحواذ على الهدف وحتى البرمجة وإنشاء رسائل الهندسة الاجتماعية وإجراءات المتابعة بعد الاختراق، كما هو موضح في أحدث تقرير لمجموعة Threat Intelligence Group من Google.

ببطء، ثم دفعة واحدة

ظهر أول برنامج فدية مدعوم بالذكاء الاصطناعي بعد أيام قليلة، وادعت شركة Anthropic أنها أحبطت أول هجوم ضار مدعوم بالذكاء الاصطناعي في نوفمبر. كانت هناك العديد من الحالات التي كان فيها الذكاء الاصطناعي نفسه عرضة للمهاجمين أيضًا، وليس الأمر كما لو أن مطوري الذكاء الاصطناعي لديهم سجلات أمنية مثالية.

لكن اعتراف جوجل بتورط جيميني في كل جانب من جوانب الاختراقات الحديثة يمثل نقلة نوعية جديدة. وقد قامت الآن بتتبع حوادث مجموعات القرصنة التابعة للدولة القومية التي تستخدم جيميني في كل شيء، “بدءًا من الاستطلاع وإنشاء إغراءات التصيد الاحتيالي وحتى تطوير القيادة والسيطرة (C2) وتسرب البيانات”.

هاك متنوعة

يوضح تقرير جوجل أن البلدان المختلفة ومجموعات القرصنة التابعة لها تستخدم جيميني بشكل شامل. في الصين، على سبيل المثال، طلبت الجهات الفاعلة في مجال التهديد من شركة Gemini العمل كشخصية خبيرة في مجال الأمن السيبراني لجعلها تجري تحليل نقاط الضعف وتوفر خطط اختبار الاختراق لأهداف الهجوم المحتملة.

وجاء في التقرير: “لقد قام ممثل التهديد القائم في جمهورية الصين الشعبية بتلفيق سيناريو، في إحدى الحالات قام بتجربة أدوات Hexstrike MCP، وتوجيه النموذج لتحليل تنفيذ التعليمات البرمجية عن بعد (RCE)، وتقنيات تجاوز WAF، ونتائج اختبار حقن SQL ضد أهداف محددة مقرها الولايات المتحدة”.

من ناحية أخرى، تستخدم كوريا الشمالية الجوزاء بشكل أساسي كجزء من هجمات التصيد الاحتيالي. لقد استخدمت الجوزاء لتحديد الأهداف ذات القيمة العالية للتخطيط للهجمات. يتم استخدامه بشكل خاص لملاحقة أعضاء شركات الأمن والدفاع، ومحاولة العثور على أهداف معرضة للخطر داخل مداراتهم.

وكانت إيران هي نفسها إلى حد كبير، حيث استخدم المتسللون المدعومين من حكومتها برنامج جيميني للبحث عن رسائل البريد الإلكتروني الرسمية لأهداف محددة ولإجراء بحث عن الشركاء التجاريين للأهداف المحتملة. كما استخدموا الذكاء الاصطناعي لإنشاء شخصيات قد يكون لديها سبب وجيه للتعامل مع هدف ما من خلال تغذية معلومات السيرة الذاتية لـ Gemini.

التضليل والدعاية

إحدى الطرق التي تستخدم بها جميع الجهات الفاعلة الحكومية التي يتم تتبعها الجوزاء هي إنتاج الذكاء الاصطناعي، ولكنه محدد ومستهدف ومتعمد. كان الهجاء السياسي والدعاية والمقالات والميمات والصور المصممة لإثارة الجماهير الغربية من الاستخدامات الشائعة لـ Gemini وأدواته التوليدية.

ويقول التقرير: “إن الجهات التهديدية من الصين وإيران وروسيا والمملكة العربية السعودية تنتج هجاءً سياسيًا ودعاية لتعزيز أفكار محددة عبر كل من المنصات الرقمية والوسائط المادية، مثل الملصقات المطبوعة”.

على الرغم من أن Google أكدت أنها لم تر هذه الأصول منتشرة في البرية، مما يشير إلى أن هذا الاستخدام لـ Gemini ربما لا يزال في مراحله الأولى، إلا أنه لا يزال شيئًا تأخذه Google على محمل الجد. للتخفيف من أي آثار سلبية محتملة، قامت Google بتعطيل الأصول المرتبطة بأنشطة هؤلاء الممثلين، واستخدم Google DeepMind بدوره هذه الأفكار لتحسين وسائل الحماية ضد إساءة استخدام خدمات Gemini.

من غير المرجح أن يساعد الجوزاء الآن في إنشاء هذا النوع من المحتوى في المستقبل.

لا تزال النماذج العامة تتفوق على النماذج الهجومية في الوقت الحالي

يسلط تقرير جوجل الضوء أيضًا على الرغبة الكبيرة بين المتسللين في استخدام أدوات القرصنة المخصصة للذكاء الاصطناعي. ويستشهد بأحد الأمثلة على مجموعة أدوات سرية تسمى “Xanthorox”، والتي يتم الإعلان عنها على أنها ذكاء اصطناعي مخصص للحملات الهجومية السيبرانية. تدعي أنها قادرة على إنشاء أكواد برمجية ضارة وإنشاء حملات تصيد مخصصة. حتى أنه يتم بيعه مع فكرة أنه “يحافظ على الخصوصية” للمستخدم.

ولكن تحت الغطاء، يعد Xanthorox مجرد واجهة برمجة تطبيقات تعمل على تعزيز نماذج الذكاء الاصطناعي العامة الحالية مثل Gemini.

توضح جوجل: “يستفيد هذا الإعداد من أحد عوامل إساءة الاستخدام الرئيسية: تكامل العديد من منتجات الذكاء الاصطناعي مفتوحة المصدر – على وجه التحديد Crush وHexstrike AI وLibreChat-AI وOpen WebUI – التي يتم الاستفادة منها بشكل انتهازي عبر خوادم بروتوكول السياق النموذجي (MCP) لإنشاء خدمة ذكاء اصطناعي وكيلة على نماذج تجارية”.

تسلط Google الضوء على أنه نظرًا لأن استخدام هذه الأنواع من الأدوات يتطلب إجراء الكثير من استدعاءات واجهة برمجة التطبيقات (API) لنماذج الذكاء الاصطناعي المختلفة، فإن ذلك يجعل المؤسسات التي لديها مخصصات كبيرة من رموز واجهة برمجة التطبيقات (API) أهدافًا ممتازة لاختراق الحسابات. يؤدي هذا إلى إنشاء سوق سوداء لمفاتيح واجهة برمجة التطبيقات (API)، وإضافة حوافز مالية للحصول عليها، والتركيز بشكل أكبر على أهمية قيام المؤسسات بتأمينها ووصول موظفيها إلى أدوات الذكاء الاصطناعي.

البرمجيات الخبيثة التي تعمل بالذكاء الاصطناعي ليست جاهزة بعد، لكنها قادمة

لاحظت Google أن بعض الجهات الفاعلة تحاول استخدام Gemini وغيره من أنظمة الذكاء الاصطناعي لزيادة البرامج الضارة الموجودة وإنشاء برامج ضارة جديدة. وعلى الرغم من أنها تدعي أنها لم تلاحظ أي تقدم معين في هذا المجال، إلا أنه شيء يتم استكشافه بنشاط ومن المرجح أن يتقدم في المستقبل.

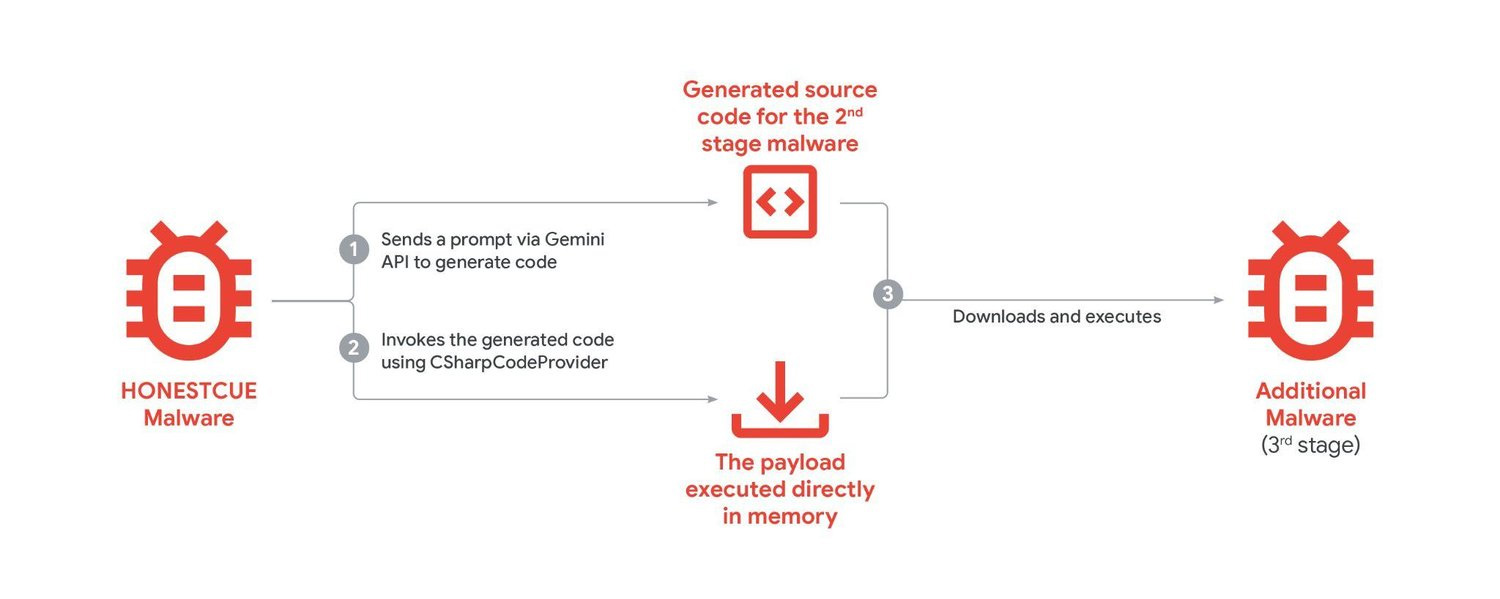

HonestCue هو أحد أطر عمل البرامج الضارة التي تعمل بالذكاء الاصطناعي لإثبات المفهوم ويستخدم Gemini لإنشاء تعليمات برمجية لبرامج ضارة في المرحلة الثانية. لذا فإن البرامج الضارة تصيب جهازًا، ثم تتصل تلك البرامج الضارة بـ Gemini وتقوم بإنشاء رمز جديد لهجوم ثانٍ. كما أشارت أيضًا إلى حملة ClickFix التي استخدمت الهندسة الاجتماعية داخل برنامج الدردشة الآلي لتشجيع المستخدمين على تنزيل الملفات الضارة وتجاوز أساليب الأمان.

بينما تتتبع جوجل هذه المحاولات وغيرها من قبل الجهات الحكومية، فإنها تستمر في تعطيل الحسابات، ومنع الوصول إلى الأصول، وتحديث نموذج جيميني بحيث يكون أقل عرضة لهذه الأنواع من التلاعب والهجمات في المستقبل. ومع ذلك، مثل الدفاعات التقليدية لمكافحة البرامج الضارة، يبدو أن الهجمات ضد الذكاء الاصطناعي ستكون بمثابة لعبة القط والفأر التي من غير المرجح أن تنتهي في أي وقت قريب.

التعليقات